Noticias

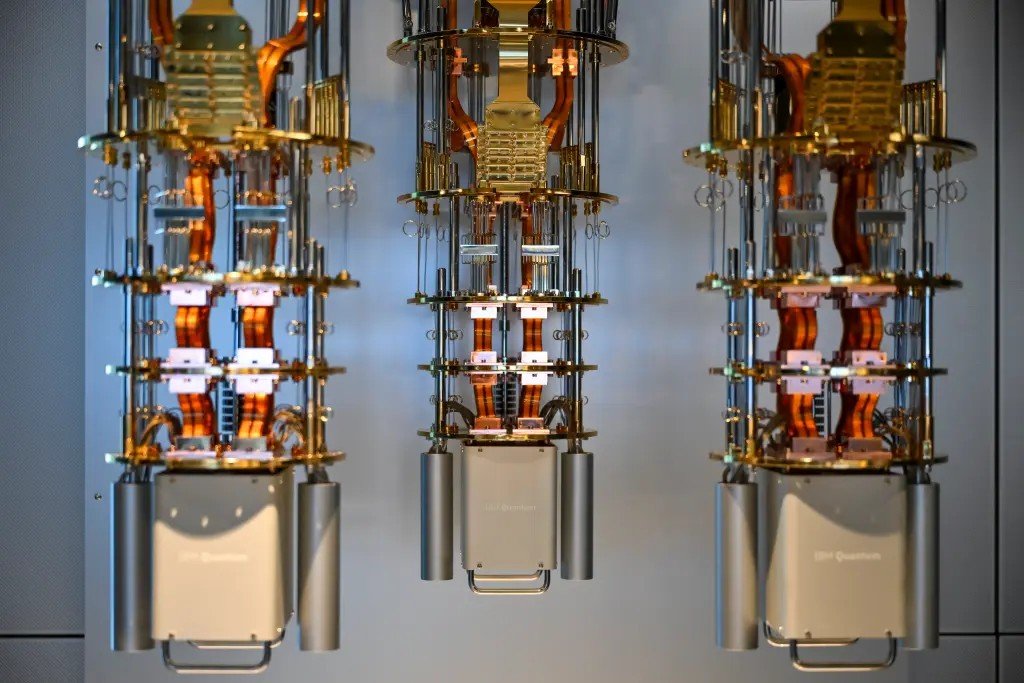

IBM y Google acercan el futuro: sistemas cuánticos a escala industrial para finales de década

Agosto 19 2025 – Tecnológicos IT

Las gigantes tecnológicas IBM y Google aseguran estar muy cerca de alcanzar un hito clave: construir computadoras cuánticas a gran escala operativas en el entorno industrial antes de que finalice la década. Según los informes más recientes, ambas empresas han logrado superar importantes obstáculos técnicos que estaban limitando hasta ahora su desarrollo.

La computación cuántica podría acelerar el descubrimiento de nuevos fármacos y tratamientos, hacer que los sistemas de inteligencia artificial sean más rápidos y más capaces y mejorar la precisión de las predicciones del mercado y la detección de fraudes en las finanzas.

También podría mejorar drásticamente la eficiencia en áreas como el encaminamiento del tráfico, el transporte marítimo, las redes de energía y las cadenas de suministro, al tiempo que impulsa la innovación ecológica ayudando a diseñar mejores baterías, sistemas de energía menos limpios y tecnologías más sostenibles.

Pero ampliarlos de menos de 200 qubits, la versión cuántica de un bit de cómputo a más de 1 millón requerirá superar formidables desafíos de ingeniería.

IBM presentó en junio un plan detallado (blueprint) que completa lagunas críticas en diseños anteriores, marcando un avance significativo en su estrategia cuántica.

Google, por su parte, logró solventar uno de los principales desafíos técnicos el año pasado y también se proyecta en camino de producir un sistema industrial completo antes de 2030.

Otras voces en el sector, como Amazon Web Services (AWS), muestran mayor prudencia, estimando que podrían pasar aún entre 15 y 30 años antes de que estas máquinas resulten realmente útiles

El principal reto radica en escalar desde menos de 200 qubits actuales hasta el orden del millón de qubits, indispensable para aplicaciones reales:

Los qubits cuánticos son extremadamente inestables y sensibles a interferencias externas. A medida que se incrementa su número, aumenta también el ruido que deteriora los cálculos cuánticos.

IBM experimentó esto con su chip Condor de 433 qubits, donde el apilamiento generó interferencias irreversibles (“crosstalk”).

Para contrarrestarlo, IBM rediseñó su sistema de acoplamiento (coupler), mejorando el control sobre los qubits.

Estrategias de corrección de errores y diseño

Ambas empresas han adoptado enfoques distintos para la corrección de errores:

Google implementa el método surface code, una arquitectura en matriz 2D de qubits que mejora a medida que el sistema escala.

IBM apuesta por low-density parity-check (LDPC) codes, una técnica teóricamente más eficiente ya que requiere hasta un 90 % menos de qubits, aunque con desafíos técnicos adicionales.

Además, se enfrentan a retos comunes como reducir la complejidad del cableado interno, como tambien a modularizar chips y ensamblarlos a mayor escala y crear sistemas de refrigeración inmensos para mantener temperaturas cercanas al cero absoluto.

Conclusión

El anuncio de IBM y Google marca un momento definitorio en la historia de la computación. Ya no se trata solo de experimentos académicos: el desarrollo de computadoras cuánticas funcionales a escala industrial está en la agenda para finales de esta década. Esto haría posible avances sin precedentes en campos tan diversos como la medicina, la energía sostenible, la optimización logística y la inteligencia artificial.

No obstante, la ruta está llena de retos: desde la fragilidad inherente de los qubits hasta el diseño, escala y refrigeración de los sistemas. Aunque el optimismo está justificadamente elevado, el balance entre innovación tecnológica y realismo estratégico será clave para determinar cuándo estas promesas cuánticas se conviertan finalmente en realidad palpable.

Un Comentario

Been using 76bet for a bit now, and I’m liking it. No complaints so far. Easy to use, and the whole thing just works. Check them out: 76bet